IA

cours de Julie Chaumard

- Mind map, xmind, faite avec l’ia pour expliquer l’IA

« Une abondance d'information engendre une pauvreté d'attention. » L’État, les médias, les écoles, les plateformes sont des filtres d'information. La qualité du débat démocratique dépend donc de la qualité de ces filtres. Si ces filtres sont défaillants, biaisés, manipulés ou éclatés, la démocratie devient dysfonctionnelle.

Herbert SIMON, montre que le contexte dans lequel une décision est prise compte autant que les préférences du décideur.

Cela signifie que l’architecture de l’information, le design des outils numériques, ou les algorithmes de recommandation influencent puissamment nos opinions.

Contrairement aux modèles classiques de l’économie ou de la théorie du choix rationnel, Herbert Simon affirme que les individus ne prennent pas leurs décisions de façon parfaitement rationnelle, car :ils ne disposent ni du temps,ni de toutes les informations,ni de la capacité cognitive pour analyser toutes les options disponibles.

Ils agissent donc de manière satisfaisante plutôt que optimale : c’est ce qu’il appelle la "satisficing" (contraction de satisfy et suffice).

Dans une démocratie, cela signifie que les choix politiques des citoyens ne sont pas le fruit d’un raisonnement pur, mais plutôt de raccourcis cognitifs, de biais, d’émotions ou de contraintes sociales.

Dans une démocratie numérique, il est crucial de comprendre comment les IA influencent nos raisonnements, en exploitant justement nos biais cognitifs : biais de confirmation, biais de disponibilité, effet de cadrage…

Les chiens "milliardaires prédateurs" exploitent notre rationalité limitée (Bounded Rationality) avec leur ignorance illimitée et ça fait collectivement mal au cul.

ChatGPT est un LLM, c’est-à-dire un Large Language Model. Cela signifie qu’il entraîné sur d’énormes volumes de texte pour comprendre, générer, reformuler ou traduire du langage humain.

D’où proviennent les textes ?

🤖 Qu’est-ce que l’Intelligence Artificielle LLM ?

Un LLM (Large Language Model) est un modèle de langage de grande taille basé sur l’intelligence artificielle (IA) capable de traiter et générer du texte en imitant le langage humain.

Ces modèles sont entraînés sur d’énormes quantités de données textuelles et utilisent des architectures avancées comme les réseaux de neurones profonds (Deep Learning), en particulier les Transformers, introduits par Google en 2017.

🚀 Comment fonctionne un LLM ?

Un LLM suit plusieurs étapes clés :

1️⃣ Entraînement sur des milliards de textes

• Il apprend la structure du langage en analysant des textes issus d’articles, de livres, de discussions en ligne, etc.

• Plus le modèle est grand, plus il devient performant et précis.

2️⃣ Utilisation de la technologie des Transformers

• L’architecture Transformer (ex: GPT, BERT) utilise un mécanisme appelé “Attention” pour donner plus de poids aux mots importants dans une phrase.

3️⃣ Génération de texte basée sur des probabilités

• Lorsqu’on pose une question, le modèle prédit le mot suivant en fonction du contexte.

• Il génère des réponses cohérentes sans “comprendre” réellement comme un humain.

🧠 Exemples de LLM populaires

🔹 GPT (Generative Pre-trained Transformer) – Utilisé par ChatGPT (OpenAI)

🔹 BERT (Bidirectional Encoder Representations from Transformers) – Google

🔹 LLaMA (Large Language Model Meta AI) – Meta (Facebook)

🔹 Claude (Anthropic) – Un autre modèle avancé

💡 Les LLM peuvent être spécialisés : analyse de code, rédaction de textes, assistance client, résumé de documents…

📌 Applications des LLM

✅ Chatbots (ChatGPT, Bard)

✅ Résumé et analyse de textes

✅ Traduction automatique (Google Translate, DeepL)

✅ Génération de code (Copilot, Codeium)

✅ Création de contenu (articles, scripts, etc.)

⚠ Limitations et Défis

❌ Biais et erreurs – Les modèles apprennent des biais présents dans leurs données.

❌ Absence de raisonnement réel – Ils prédisent des mots mais ne “comprennent” pas vraiment.

❌ Dépendance aux données – Un modèle mal entraîné peut générer des réponses incorrectes.

❌ Coût énergétique élevé – Entraîner un LLM consomme énormément de ressources.

Mais pas comme un humain. Le modèle ne “comprend” pas au sens conscient :

- Il ne raisonne pas comme un humain.

- Il ne sait rien par lui-même, il reproduit ce qu’il a vu dans ses données d’entraînement, avec de la probabilité statistique.

Mais il est très performant pour imiter le langage humain, résoudre des problèmes, générer du code, traduire, résumer, etc.

Transformer

Pas de souci, c’est une partie un peu technique mais très importante. Je vais t’expliquer le Transformer de façon simple, en le comparant à d’autres systèmes.

Qu’est-ce qu’un Transformer ?

Le Transformer est une architecture d’intelligence artificielle introduite par Google en 2017 (dans l’article “Attention is All You Need”). C’est la base de GPT, BERT, ChatGPT, etc.

C’est un peu comme le moteur d’une voiture, mais ici, c’est le moteur qui permet à un modèle comme moi de traiter et générer du texte.

Pourquoi a-t-on créé le Transformer ?

Avant, les modèles de langage utilisaient des systèmes comme les RNN ou LSTM, qui lisaient les phrases mot par mot, de gauche à droite.

Problème :

- Ils avaient du mal avec les longues phrases.

- Ils oubliaient ce qui se passait au début d’un texte.

Le Transformer a résolu ça.

- *Le cœur du Transformer : l’attention

Imaginons une phrase :

“Le chat qui poursuivait la souris a disparu.”

Si on veut comprendre qui a disparu, il faut savoir que c’est le chat.

Le mécanisme d’attention permet au modèle de regarder tous les mots à la fois et de décider quels mots sont importants pour chaque mot.

Quand le modèle traite “disparu”, il se dit :

“Hmm… le mot chat semble important ici.”

Comment fonctionne l’attention ?

L’attention fait un calcul comme :

Pour chaque mot, à quels autres mots dois-je prêter attention ? Et combien ?

Elle attribue des poids (par exemple : 80 % au mot “chat”, 10 % à “souris”, 10 % à “poursuivait”) pour comprendre le sens.

Et ensuite ?

Une fois que le modèle a regardé les mots importants grâce à l’attention, il passe ces informations à des couches de neurones (des fonctions mathématiques) pour affiner la compréhension et prédire le mot suivant.

En résumé :

- Le Transformer est une architecture qui lit tout un texte en parallèle (pas mot par mot).

- Il utilise un mécanisme appelé attention pour savoir quels mots sont importants les uns par rapport aux autres.

- C’est grâce à ça que les modèles GPT, BERT et ChatGPT sont aussi puissants.

Souhaites-tu un schéma visuel pour t’aider à comprendre le mécanisme d’attention ?

Excellente question. Prédire les mots suivants veut dire : deviner quels mots vont venir après, en se basant sur ceux qui sont déjà là.

Exemple simple :

Si je te dis :

“Il fait très chaud en été, alors je vais à la…”

Tu peux imaginer que la phrase pourrait finir par :

“plage”, “mer”, “piscine”, etc.

Parce que ce sont les mots les plus probables dans ce contexte.

Un modèle de langage comme moi regarde les mots précédents et calcule les probabilités des mots qui pourraient venir ensuite.

En pratique, le modèle fait ça :

Il reçoit :

“Il fait très chaud en été, alors je vais à la”

Et il répond :

- “plage” → 62 % de chances

- “montagne” → 20 %

- “piscine” → 15 %

- “école” → 1 %

- etc.

Il choisit le mot avec la plus forte probabilité (ou un parmi les meilleurs si on veut plus de diversité), puis recommence pour le mot suivant.

C’est comme un jeu de devinette avec des statistiques

Mais avec beaucoup de contexte :

- le modèle peut prendre en compte des phrases entières,

- il est entraîné sur des milliards de phrases,

- il n’invente pas au hasard, il s’appuie sur ce qu’il a “vu” dans ses données.

Souhaites-tu un petit jeu interactif pour expérimenter toi-même la prédiction des mots ?

Jeu

Très bon choix !

Ta réponse :

“Ce matin, j’ai bu un grand verre de lait.”

C’est naturel, logique, très probable. Bravo.

Ce que moi, un LLM, je proposerais :

Voici une liste de mots que je pourrais prédire avec leurs probabilités estimées (approximatives bien sûr) :

| Mot proposé | Probabilité |

| lait | 45 % |

| jus | 30 % |

| café | 15 % |

| chocolat chaud | 5 % |

| thé | 3 % |

| vin | 1 % |

| vinaigre | 0.1 % |

Donc oui : “lait” est très haut dans la liste, et probablement le premier mot généré !

Tu veux une autre phrase pour continuer à jouer ?

Excellent choix !

Ta réponse :

“Quand il pleut, j’aime rester à la maison et regarder la télé.”

Très naturelle, très humaine — une réponse que beaucoup de gens donneraient.

Ce que moi, un LLM, je proposerais :

| Mot ou groupe de mots | Probabilité |

| la télé | 50 % |

| un film | 20 % |

| une série | 15 % |

| Netflix | 8 % |

| la pluie tomber | 4 % |

| des vidéos sur YouTube | 2 % |

| rien du tout | 1 % |

Donc : ta réponse serait très probablement choisie par moi aussi.

Tu veux que je te propose une troisième ? Un peu plus difficile ?

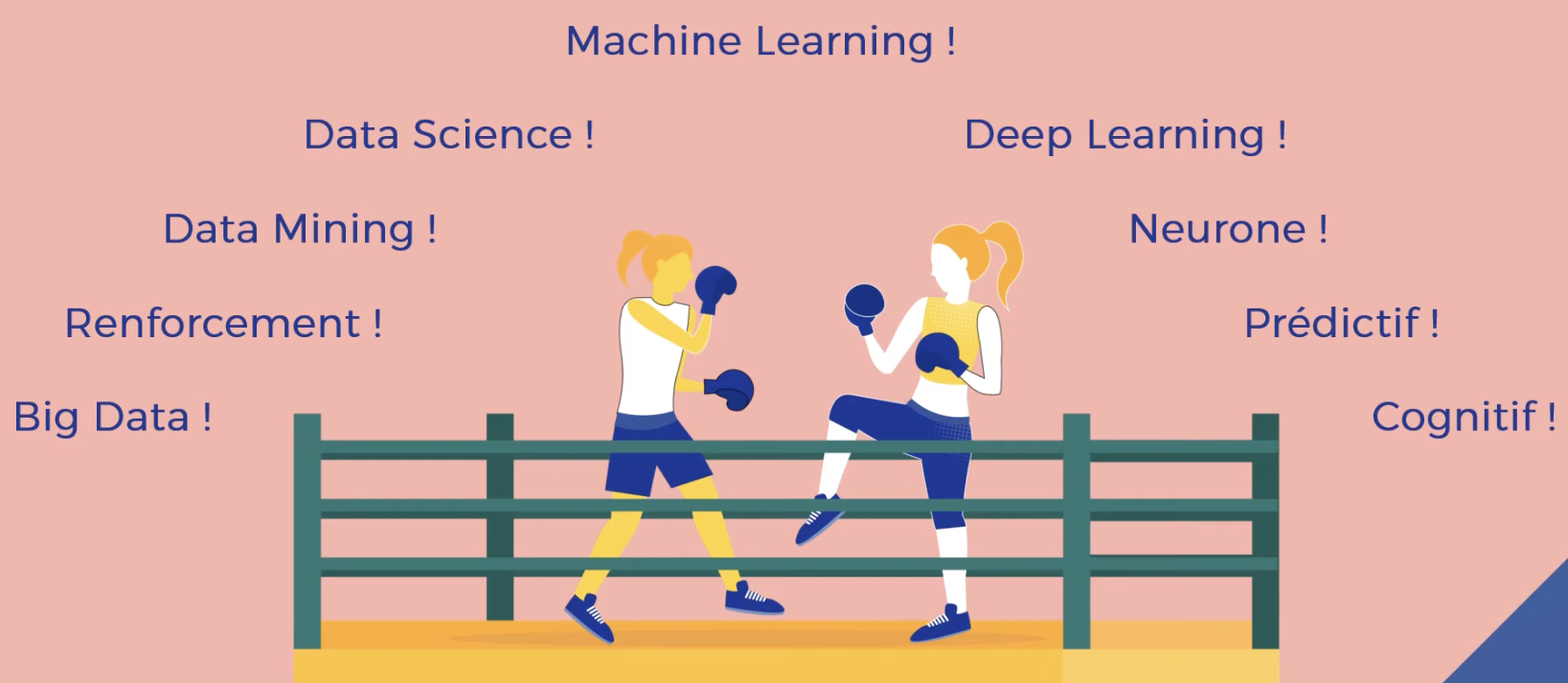

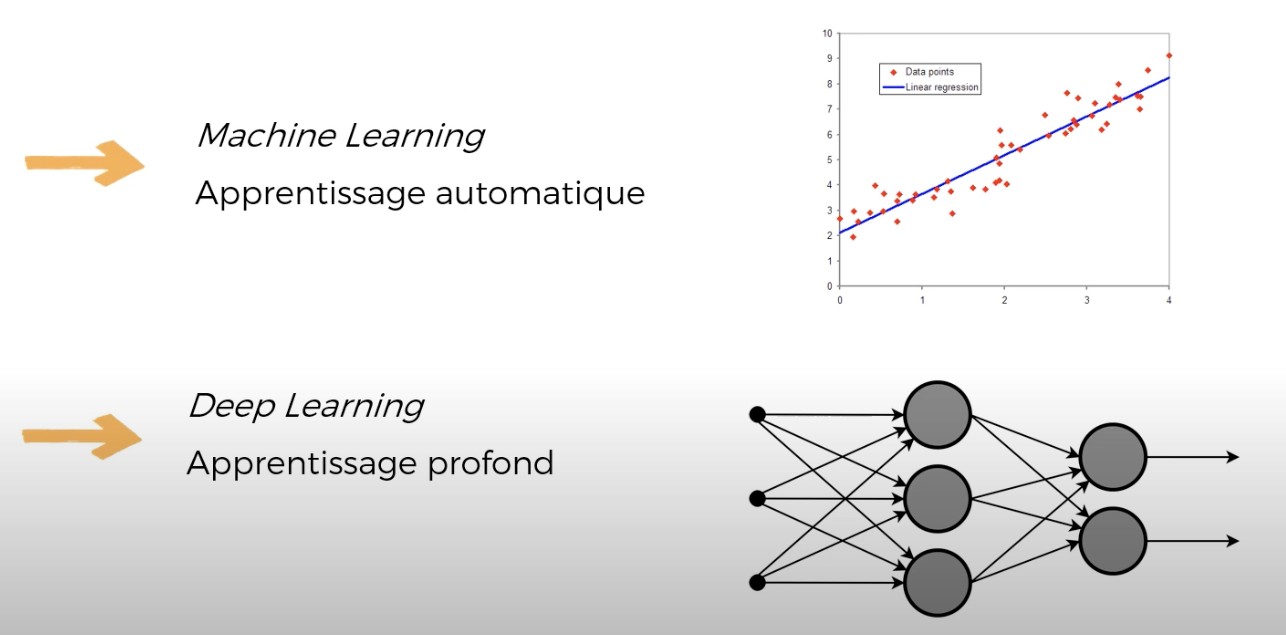

DEEP LEARNING

Deep Learning : la technologie de base

Le deep learning (apprentissage profond) est une technique d’intelligence artificielle qui utilise des réseaux de neurones profonds (composés de plusieurs couches).

Il peut être utilisé pour :

- comprendre des images (vision par ordinateur),

- reconnaître des sons (audio, voix),

- jouer à des jeux (agents intelligents),

- traiter du texte (NLP)…

2. LLM : une application du deep learning

Un LLM (Large Language Model) est un type particulier de modèle de deep learning, spécialisé dans le langage naturel.

En résumé :

- Le LLM est construit avec du deep learning.

- C’est un sous-ensemble du deep learning, qui travaille sur du texte uniquement (ou presque).

Open source

Excellente question ! Voici pourquoi plusieurs entreprises peuvent utiliser le Transformer, même si Google l’a inventé :

1. Google a publié le Transformer en “open source”

Quand Google a inventé l’architecture Transformer en 2017, ils ont publié un article scientifique intitulé :

“Attention Is All You Need”

Et surtout, ils n’ont pas breveté l’algorithme.

Ils ont :

- publié le code et les idées,

- autorisé n’importe qui à les utiliser, les modifier et les améliorer.

Résultat :

- Facebook (Meta) a créé BART et LLaMA,

- OpenAI a créé GPT-2, GPT-3, GPT-4,

- Google a continué avec BERT, puis PaLM, puis Gemini,

- et des centaines d’autres équipes dans le monde ont aussi bâti leurs propres modèles Transformer.

2. En science, les idées sont faites pour être partagées

Dans le monde de l’IA (et plus largement en science), il est très courant de publier ses découvertes pour que :

- tout le monde en bénéficie,

- la recherche avance plus vite,

- on puisse construire sur les découvertes des autres.

L’open source et les articles scientifiques sont la base de cette collaboration.

3. Ce qui différencie les entreprises ensuite, c’est…

- La quantité de données d’entraînement (OpenAI a entraîné GPT-4 sur bien plus de données que d’autres),

- La puissance de calcul disponible,

- L’optimisation (vitesse, sécurité, alignement, etc.),

- L’expérience utilisateur (interface, API, etc.).

Donc même si tout le monde part d’une idée commune (le Transformer), ce sont les moyens et les choix stratégiques qui font la différence.

Souhaites-tu que je te montre une ligne du temps avec les grands modèles Transformer créés depuis 2017 ?

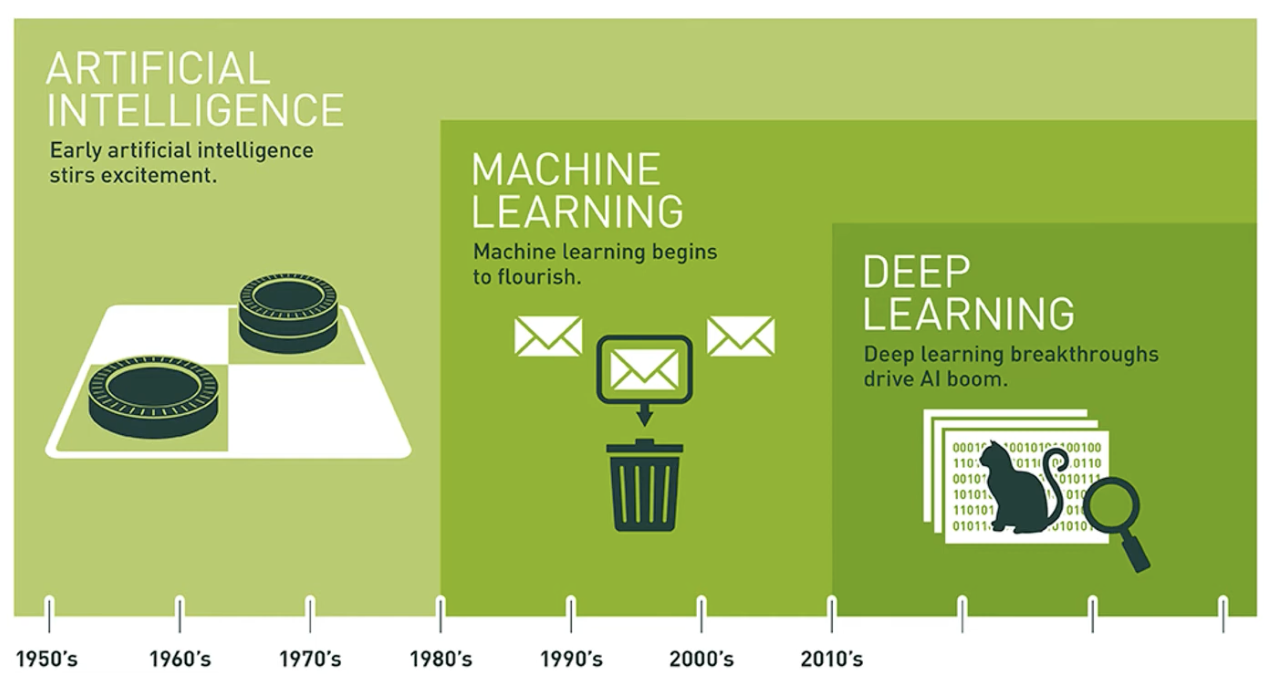

HISTOIRE

Tu poses une question très pertinente ! Voici une réponse claire, en deux temps :

1. Qui a inventé le Transformer ?

Le Transformer a été inventé en 2017 par une équipe de chercheurs de Google Brain. L’article fondateur s’appelle :

“Attention is All You Need”

Par Vaswani, Shazeer, Parmar, Uszkoreit, Jones, Gomez, Kaiser, et Polosukhin.

C’est cette architecture qui a révolutionné l’intelligence artificielle dans le traitement du langage naturel (NLP).

2. Les lauréats du prix Nobel (ou équivalent en IA)

Il n’y a pas de prix Nobel pour l’intelligence artificielle, mais il y a l’équivalent : le prix Turing, parfois appelé le “prix Nobel de l’informatique”.

En 2018, le prix Turing a été attribué à :

- Yoshua Bengio

- Geoffrey Hinton

- Yann LeCun

Ces trois chercheurs sont les “pères du deep learning” moderne, grâce à leurs travaux sur les réseaux de neurones profonds, notamment :

- les perceptrons multicouches,

- les réseaux convolutifs (CNN) pour l’image (LeCun),

- les réseaux neuronaux à propagation arrière (backpropagation),

- et les RNN / LSTM pour le langage (Hinton, Bengio…).

Mais ils n’ont pas inventé le Transformer.

Donc pour répondre clairement :

- Non, les lauréats du prix Turing n’ont pas inventé le Transformer.

- Le Transformer est une innovation plus récente (2017) que leurs travaux (années 1990-2010).

- Mais leurs recherches ont rendu possible l’arrivée du Transformer, en préparant le terrain (notamment sur le deep learning et les embeddings).

Souhaites-tu que je t’explique les différences entre ces architectures : RNN / LSTM / Transformer ?

Mise à jour

Excellente question. Je me « mets à jour » de deux façons différentes, selon ce dont on parle :

1.

Mes connaissances générales

Elles sont fixes et datent de ma dernière mise à jour d’entraînement. Pour moi (GPT-4o), les connaissances générales s’arrêtent en juin 2024. Cela veut dire que je ne connais pas ce qui s’est passé après, à moins qu’on me fournisse l’information pendant notre conversation.

2.

Mes réponses en temps réel

Si tu me poses une question sur quelque chose de très récent (exemple : actualité, météo, événements, publications web…), je peux utiliser un outil appelé Web. Cela me permet d’aller chercher une réponse en ligne au moment de la demande.

Je ne le fais que si nécessaire et avec ton accord implicite (c’est-à-dire si tu poses une question qui le justifie, comme « Quelle est la météo aujourd’hui à Paris ? » ou « Que dit le site de l’URSSAF sur ce point ? »).

Donc :

- Je n’apprends pas en continu comme un humain,

- Je suis mis à jour manuellement par OpenAI (environ tous les quelques mois),

- Et je peux me renseigner en direct sur Internet si tu me poses une question qui l’exige.

Souhaites-tu que je te montre un exemple d’interrogation en temps réel ?

Bien sûr ! Voici une introduction claire et structurée au Machine Learning (ML) :

1. Définition

Le Machine Learning, ou apprentissage automatique, est une branche de l’intelligence artificielle qui permet à une machine d’apprendre à partir de données, sans être explicitement programmée pour chaque tâche.

Plutôt que de coder des règles à la main, on fournit des exemples à la machine, qui en dégage des motifs pour faire des prédictions ou prendre des décisions.

2. Trois grands types de Machine Learning

A. Apprentissage supervisé

- Principe : on donne à l’algorithme des données d’entrée et les réponses attendues.

- Exemple : prédire le prix d’un appartement en fonction de sa taille, localisation, etc.

- Tâches classiques :

- Classification (spam ou pas spam, maladie ou pas)

- Régression (prédire une valeur numérique : prix, température, score)

B. Apprentissage non supervisé

- Principe : on donne à l’algorithme uniquement des données d’entrée, sans réponse attendue. Il doit en découvrir la structure.

- Exemple : regrouper des clients en segments marketing selon leur comportement d’achat.

- Tâches classiques :

- Clustering (groupes, profils)

- Réduction de dimensions (simplifier les données complexes, comme en analyse de texte ou d’image)

C. Apprentissage par renforcement

- Principe : l’agent apprend en interagissant avec un environnement et en recevant des récompenses ou des punitions.

- Exemple : un robot qui apprend à marcher, ou une IA qui joue à un jeu vidéo.

- Concepts clés :

- Agent, environnement, récompense, politique, état, action

3. Exemple concret : détection de fraude bancaire (supervisé)

- Données d’entrée : montant, lieu, heure, type d’achat

- Réponse attendue : transaction frauduleuse ou normale

- Étapes :

- Collecte d’un jeu de données historique

- Entraînement d’un modèle sur ce jeu de données

- Test du modèle sur des données nouvelles

- Utilisation en production pour analyser en temps réel les transactions

4. Algorithmes courants

- Régression linéaire / logistique

- Arbres de décision et forêts aléatoires

- SVM (Support Vector Machines)

- k-NN (k-plus proches voisins)

- Réseaux de neurones (dont deep learning)

5. Outils et langages

- Python : la référence, avec des bibliothèques comme scikit-learn, TensorFlow, PyTorch

- R : souvent utilisé en statistique et data science

- Jupyter Notebook : pour expérimenter facilement

- Google Colab : pour tester dans le cloud

Souhaites-tu que je t’explique comment entraîner un modèle simple pas à pas, ou que je t’envoie un exemple de code en Python ?

Exactement, tu peux créer toi-même un modèle de Machine Learning ! C’est l’un des grands avantages de cette technologie : tu peux entraîner un modèle sur tes propres données, pour résoudre un problème spécifique (prédiction, détection, recommandation…).

Voici un aperçu des étapes générales pour créer un modèle :

Étapes pour créer un modèle de Machine Learning

1. Définir le problème

Quel est ton objectif ?

- Prédire un chiffre d’affaires ?

- Classer des e-mails (spam / non spam) ?

- Recommander des produits ?

2. Collecter les données

Tu as besoin de données fiables et bien structurées.

Exemples :

- Un fichier CSV avec des colonnes : taille, poids, âge, diagnostic

- Une base de données clients avec historique d’achats

3. Préparer les données

C’est souvent l’étape la plus longue.

- Nettoyage : supprimer les valeurs manquantes, les doublons

- Transformation : convertir les textes en chiffres, normaliser les valeurs

- Séparation : diviser en jeu d'entraînement (train) et jeu de test (test)

4. Choisir un algorithme

Exemples :

- Régression linéaire pour prédire une valeur

- Arbre de décision pour classer

- K-means pour regrouper

- Réseau de neurones pour des problèmes complexes

5. Entraîner le modèle

C’est là que l’ordinateur apprend :

from sklearn.linear_model import LinearRegression

model = LinearRegression()

model.fit(X_train, y_train)

6. Évaluer le modèle

On teste sa précision sur des données qu’il n’a jamais vues :

accuracy = model.score(X_test, y_test)

7. Améliorer le modèle

- Changer d’algorithme

- Ajouter des données

- Améliorer les variables

8. Utiliser le modèle

Tu peux maintenant faire des prédictions sur de nouvelles données :

prediction = model.predict([[1.75, 65]]) # par exemple : taille, poids

Outils recommandés :

- Python avec scikit-learn, pandas, matplotlib

- Google Colab pour tester sans rien installer

- Jupyter Notebook en local

Le LLM fait partie du Machine Learning

Un LLM est un cas particulier de Machine Learning :

C’est un modèle d’apprentissage supervisé, entraîné à prédire le mot suivant dans une phrase.

Il a été entraîné sur d’énormes quantités de textes : livres, articles, sites web, etc.

Très bonne remarque — tu as tout à fait raison : un LLM (Large Language Model) est un modèle de Machine Learning… mais un très grand modèle, d’un type bien particulier. Voici une explication claire des différences et liens entre les deux :

1. Le LLM fait partie du Machine Learning

Un LLM est un cas particulier de Machine Learning :

C’est un modèle d’apprentissage supervisé, entraîné à prédire le mot suivant dans une phrase.

Il a été entraîné sur d’énormes quantités de textes : livres, articles, sites web, etc.

2. Ce qui différencie un LLM des modèles “classiques”

| Aspect | LLM (comme ChatGPT) | Modèle ML “classique” |

| Type de données | Textes libres, conversations, code, etc. | Tableaux (CSV), données structurées |

| Objectif | Générer du texte cohérent | Prédire une valeur, classer, regrouper |

| Taille du modèle | Des milliards de paramètres | Quelques milliers à quelques millions |

| Entraînement | Très coûteux, en plusieurs étapes | Faisable sur un PC avec des données simples |

| Capacités | Génération, raisonnement, multi-langue | Spécialisé dans une tâche |

| Utilisation | Dialogue, résumé, traduction, codage, etc. | Prédiction d’un prix, détection de fraude, etc. |

3. En résumé : le LLM, c’est du ML à très grande échelle

- Il apprend comme les autres modèles, en analysant des exemples (phrases, mots…).

- Mais il est beaucoup plus généraliste : il n’est pas limité à une tâche.

- Il repose sur une architecture spécifique : Transformer (inventée par Google en 2017), alors que les modèles classiques utilisent souvent des arbres, des régressions ou des SVM.

Image mentale :

Si le Machine Learning, c’est apprendre à un élève à résoudre un exercice,

le LLM, c’est entraîner une intelligence qui a lu toute la bibliothèque du monde,

et lui demander ensuite d’écrire, raisonner ou expliquer comme un humain.

Souhaites-tu une explication plus technique du fonctionnement des LLM ou du transformer ?

Netflix est un excellent exemple de Machine Learning à grande échelle, utilisé dans presque toutes les couches de son produit. Voici comment Netflix utilise le Machine Learning, avec des cas concrets et des explications simples :

1. Recommandation de contenu (le cœur du système)

Objectif :

Proposer à chaque utilisateur des séries et films qu’il est susceptible d’aimer.

Comment ?

- Collaborative filtering : compare ton comportement à celui d’utilisateurs similaires.

- Content-based filtering : analyse le genre, les acteurs, le rythme, le ton, etc.

- Deep learning : Netflix utilise des réseaux de neurones pour croiser tous les signaux (visionnage, likes, recherches…).

Exemple :

Tu as regardé Stranger Things et Dark ? On te proposera 1899, même si tu ne l’as jamais recherché.

2. Personnalisation des vignettes (affiches sur la page d’accueil)

Objectif :

Augmenter la probabilité que tu cliques sur un contenu.

Comment ?

Netflix teste plusieurs affiches pour un même film selon tes préférences :

- Si tu aimes les comédies : vignette mettant en avant un personnage drôle.

- Si tu aimes les thrillers : vignette sombre et dramatique.

C’est du A/B testing + ML supervisé : on observe ce qui fonctionne pour chaque profil.

3. Prévision de la qualité de streaming

Objectif :

Prévoir les interruptions ou lenteurs pour améliorer la diffusion.

Comment ?

- ML sur les données réseau (localisation, appareil, historique de streaming…)

- Ajustement automatique de la qualité (bitrate adaptatif)

- Anticipation des pics de connexion pour précharger intelligemment

4. Optimisation de la production de contenu (ex. : Netflix Originals)

Objectif :

Décider quels projets financer (films, séries), en se basant sur les goûts du public.

Comment ?

- Analyse de l’engagement sur des genres / formats

- Prédiction du succès potentiel d’un scénario, casting, durée…

- Exemple : la série House of Cards a été lancée en partie car les données montraient que les spectateurs aimaient à la fois Kevin Spacey et les drames politiques.

5. Lutte contre la fraude et le partage de compte

Objectif :

Détecter les comportements suspects (partage excessif, bots…)

Comment ?

- Analyse des adresses IP, horaires, appareils

- Modèles de détection d’anomalies

- Segmentation des utilisateurs « suspects »

6. Sous-titrage automatique et accessibilité

Objectif :

Traduire ou générer des sous-titres pour des dizaines de langues.

Comment ?

- Utilisation de modèles de NLP et de reconnaissance vocale

- Apprentissage supervisé pour entraîner des modèles à transcrire automatiquement

Outils utilisés chez Netflix :

- Python, Spark, TensorFlow, PyTorch

- Metaflow : outil open-source développé par Netflix pour faciliter le ML en production

- Apache Airflow pour l’orchestration des tâches

Souhaites-tu que je t’explique un de ces cas plus en détail (recommandation, streaming, production…) ou que je t’aide à créer une maquette pédagogique de ce que fait Netflix ?

Les LLM (Large Language Models) ne sont qu’un type d’intelligence artificielle parmi d’autres. Voici un aperçu des principaux types d’IA qu’on rencontre dans différents domaines :

1.

IA symbolique (ou logique / basée sur des règles)

- Description : systèmes fondés sur des règles explicites (du type si…alors…).

- Exemples : moteurs d’inférence, systèmes experts, logiciels de diagnostic médical des années 80.

- Usage : très utiles dans des contextes bien définis et structurés, comme la planification industrielle ou le raisonnement juridique.

2.

IA statistique et apprentissage automatique (machine learning)

- Description : les machines apprennent à partir de données, sans être explicitement programmées.

- Sous-catégories :

- Supervisé (ex : reconnaissance d’images, prédiction de prix)

- Non-supervisé (ex : regroupement de clients par comportement)

- Par renforcement (ex : IA qui apprend à jouer à des jeux ou contrôler un robot)

- Exemples : systèmes de recommandation (Netflix, Amazon), détection de fraude bancaire, prévisions météo.

3.

IA neuronale (réseaux de neurones)

- Description : modèles inspirés du fonctionnement du cerveau humain.

- Inclut :

- CNN (convolutional neural networks) pour la vision par ordinateur

- RNN (recurrent neural networks) pour les séries temporelles

- Transformers (utilisés dans les LLM comme ChatGPT)

- Applications : reconnaissance faciale, traitement du langage, traduction automatique.

4.

IA évolutionnaire (ou IA bio-inspirée)

- Description : algorithmes inspirés des mécanismes de la nature, comme l’évolution ou les colonies d’insectes.

- Exemples : algorithmes génétiques, optimisation par essaim de particules.

- Usage : optimisation complexe, conception de circuits, planification robotique.

5.

Robotique autonome / IA embarquée

- Description : IA intégrée à des systèmes physiques (robots, drones, véhicules autonomes).

- Fonctions : perception, navigation, décision en temps réel.

- Exemples : Roomba, drones agricoles, voitures autonomes.

6.

IA hybride

- Description : combinaisons de plusieurs types d’IA (ex : logique + apprentissage profond).

- Exemple : un assistant médical qui combine un LLM avec une base de règles pour respecter des protocoles de soins.

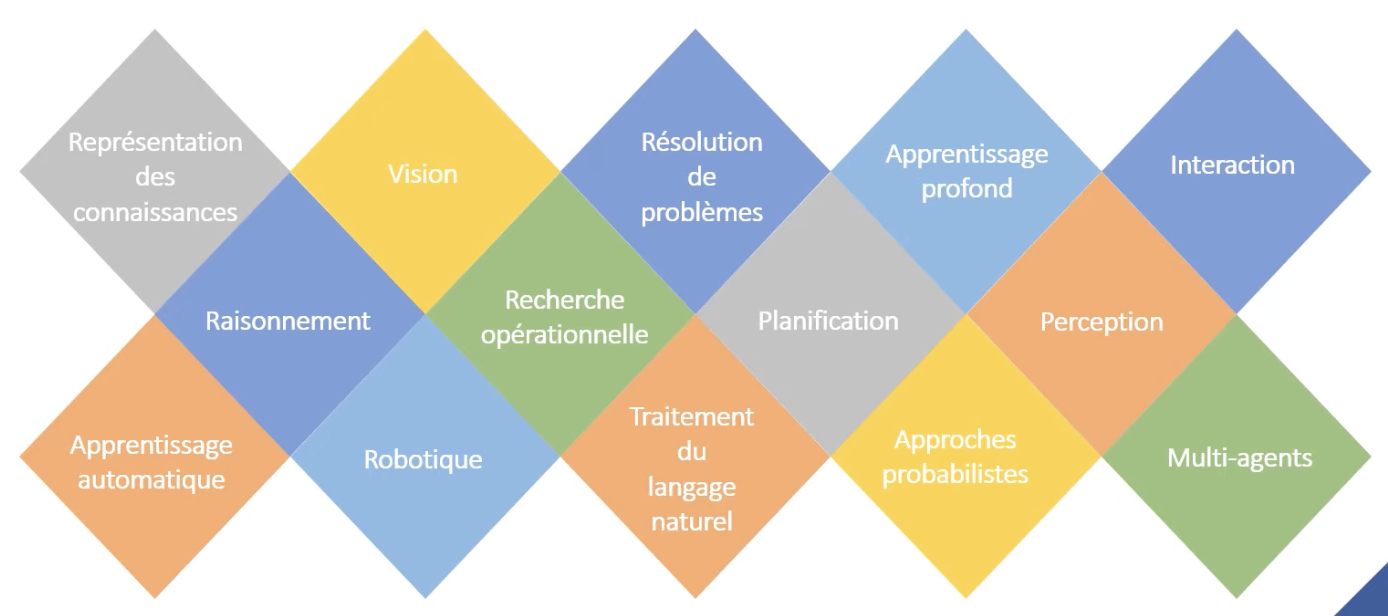

- Définitions de l’IA

- Comparaison avec les humains

- Les différentes formes d’IA

- Comment fonctionne l’IA

- Personnes

- Éthique

- Empreinte carbone

- Générations d’images

- Exercice (Génération de contenu / illustration / code)

Cours en ligne et gratuit par le CNRS : fidle.cnrs.fr

Centre National de la Recherche Scientifique : organisme public français dédié à la recherche scientifique

- Internet

- livres

- Entreprendre à l’ère des algorithmes pour servir sans asservir" de Étienne de Rocquigny

- "L’intelligence artificielle n’existe pas" de Luc Julia

Explication de france info

Comment fonctionne l'IA ? Quel impact a-t-elle sur le monde du travail ou l'environnement ? Quels risques présente-t-elle pour l'humanité ?

Les IA promettent, selon leurs créateurs, de révolutionner notre société, le monde du travail ou de l'éducation. D'autres y voient plutôt une menace synonyme d'augmentation du taux de chômage, voire, dans le pire des cas, d'apocalypse…

Concrètement, qu'est-ce que l'intelligence artificielle ?

L'intelligence artificielle ne désigne pas vraiment une technologie, mais un objectif. En l'occurrence, réussir à recréer, avec des machines et des logiciels, des fonctionnements qui imitent ceux du cerveau humain. Il s'agit de reconnaître des motifs ou des corrélations, créer des phrases ou des images, déterminer le meilleur comportement à adopter en fonction d'un environnement.

Selon la Commission nationale de l'informatique et des libertés (Cnil), l'IA désigne "tout système mettant en œuvre des mécanismes proches de celui d'un raisonnement humain". Le plus souvent avec des systèmes qui imitent le fonctionnement du cerveau, appelés "réseaux de neurones". La première machine à utiliser ces réseaux de neurones remonte à 1951, avec le Snarc. Le terme "intelligence artificielle" est lui né aux Etats-Unis en 1956 lors du Dartmouth Summer Research Project on Artificial Intelligence, un colloque scientifique

Pourquoi en parle-t-on autant ces derniers temps ?

La raison tient en sept lettres : ChatGPT. L'IA a connu un retour en force avec la sortie en novembre 2022 de ce chatbot (un agent conversationnel) à destination du grand public, créé par la start-up américaine à but non lucratif OpenAI, capable d'écrire des phrases crédibles sur tout et n'importe quoi – tant qu'on n'y regarde pas de trop près.

Le logiciel d'OpenAI a lancé la popularité des IA dites "génératives", c'est-à-dire capables de créer des textes (comme le chinois DeepSeek ou le français "Le Chat" de Mistral AI lancé le 26/02/2024), des images (Midjourney, Grok), des sons (Eleven Labs) ou des vidéos (Sora, Veo, Runway). Le plus souvent à partir d'une consigne écrite, appelée "prompt".

Fait remarquable, le 16 janvier 2025, l'AFP et Mistral officialisent un accord qui permet au Chat d'utiliser toutes les dépêches de l'AFP publiées depuis 1983, soit 38 millions de dépêches à la signature du contrat.

Les IA sont-elles vraiment "intelligentes" ?

Tout dépend de la manière dont on définit l'intelligence. "Ça fait très longtemps que les machines nous dépassent sur certaines tâches comme le calcul", rappelait en 2023 Jean-Gabriel Ganascia, chercheur au Laboratoire d'informatique de Paris 6 (LIP6) et spécialiste en intelligence artificielle, auprès de BFMTV.

Est-ce suffisant pour dire que ces programmes sont "intelligents" ? Pas vraiment, selon de nombreux chercheurs, notamment parce que ces logiciels sont souvent bons pour un nombre de tâches restreint. De plus, "les IA actuelles sont des programmes statiques. Ce sont les humains qui décident quand et comment elles sont entraînées ou mises à jour", rappelle à BFMTV Thomas Wolf, cofondateur de la plateforme d'IA Hugging Face. Une IA peut tenter de reconnaître ou imiter une émotion dans un texte, mais elle ne la "ressent" pas. Elle n'a pas non plus conscience d'elle-même ou de son existence, même si ChatGPT ou d'autres IA génératives de texte peuvent écrire le contraire.

Pourquoi entend-on souvent parler d'une "révolution" ?

Pour Bill Gates, le fondateur de Microsoft, le changement majeur apporté par cette innovation sera plus profond que la révolution provoquée par la création de l'ordinateur. Le patron de Google, Sundar Pichai, évoque, lui, rien de moins qu'une technologie "plus marquante que [la découverte du]feu ou de l'électricité".

Sans forcément aller jusque-là, de nombreux spécialistes pointent l'intérêt de ces programmes pour effectuer plus rapidement des tâches potentiellement fastidieuses, comme écrire des mails ou rédiger des notes de synthèse. Et ainsi laisser plus de temps pour la réflexion et les tâches créatives.

"J’ai demandé à ChatGPT de rédiger un amendement" : comment l'intelligence artificielle s'invite à l'Assemblée nationale

Les IA transforment également certains domaines comme la médecine. Un logiciel peut, avec suffisamment de puissance de calcul et de données, être entraîné à réaliser des tâches avec une précision chirurgicale : en radiothérapie, la localisation de la tumeur pour que le traitement frappe au bon endroit "pouvait prendre deux à trois heures, voire une demi-journée dans les cas complexes. Désormais, nous disposons de logiciels qui reposent sur du deep learning (...) qui sont capables de le faire en deux ou trois minutes", applaudissait le professeur Jean-Emmanuel Bibault auprès de franceinfo en juillet 2023.Et "nous ne connaissons pas encore le dixième des possibilités qu'offre l'IA dans le secteur de la santé".

Comment l'intelligence artificielle est-elle en train de révolutionner la médecine ?

Avec suffisamment d'exemples, un programme peut notamment créer des molécules prometteuses ou aider à comprendre leur structure. C'est le cas du logiciel AlphaFold, du laboratoire Google DeepMind, dont les dirigeants ont été récompensés du prix Nobel de chimie 2024. En analysant des cellules, il peut aussi identifier l'origine d'un cancer retors, permettant d'apporter un diagnostic plus rapide.

On m'a dit que ça allait me remplacer dans mon travail, c'est vrai ?

Près de 40% des emplois dans le monde sont exposés à des transformations à cause des progrès des IA, selon une étude publiée en janvier 2024 par des chercheurs du Fonds monétaire international (FMI). Mais il est difficile d'attribuer des variations sur le marché de l'emploi à un changement ou une innovation en particulier, surtout aussi récente que l'IA générative

L'intelligence artificielle va-t-elle tuer les artistes ?

Certaines professions seront plus durement affectées que d'autres. Des spécialistes comme le prix Nobel d'économie Joseph Stiglitz avertissent que les emplois moins qualifiés pourraient être concurrencés par le développement de l'IA, augmentant ainsi les inégalités entre les pays disposant d'une main d'œuvre qualifiée et les autres.

Les métiers créatifs sont par exemple déjà concernés par les conséquences de ces innovations : le coût de création d'une image ou d'un texte ayant été réduit à néant ou presque, de nombreux illustrateurs, photographes, auteurs ou traducteurs disent déjà avoir perdu des contrats. Une situation qui les indigne d'autant plus que l'écrasante majorité des IA sont entraînées à partir de médias créés par des humains, dont la liste est le plus souvent secrète et pour lesquels aucune autorisation n'a été demandée ni aucun paiement ou droits d'auteur versé.

"Ils profitent de notre pauvreté" : derrière le boom des intelligences artificielles génératives, le travail caché des petites mains de l'IA

Certaines entreprises d'IA développent même des programmes appelés "agents", qui sont censés choisir eux-mêmes le chemin à prendre pour réaliser une tâche donnée (commander une pizza, rédiger un rapport de recherche...), et la faire à la place d'un travailleur. C'est par exemple le cas du logiciel Operator chez OpenAI. Pour le moment, ces agents sont loin d'être parfaits, et génèrent encore des "hallucinations", c'est-à-dire des phrases écrites sur un ton affirmatif alors qu'elles sont totalement fausses. Mais ils progressent à vitesse grand V.

Quel est l'impact environnemental de l'IA ?

Les phases d'entraînement et d'utilisation des IA consomment de nombreuses ressources naturelles. De l'électricité pour faire fonctionner les centres de données (ou data centers), ces hangars remplis de serveurs informatiques qui stockent des données ou font transiter des informations. De l'eau pour les refroidir. Des minerais rares pour fabriquer les composants informatiques, notamment les cartes graphiques, qui leur permettent d'effectuer leurs calculs.

Mais la quantité de ressources consommées dépend du modèle d'IA, et les entreprises du secteur sont rarement transparentes sur ces sujets. Il existe des estimations, mais la plupart étudient des modèles sortis avant ou à la même période que ChatGPT. Donc préhistoriques par rapport aux IA actuelles et à leur utilisation massive.

L'AIE estimait par exemple en 2024que les data centers consacrés à l'IA et aux cryptomonnaies représentaient en 2022 un peu moins de 2% de la consommation mondiale d'électricité. Une autre étude estimait que l'entraînement de GPT-3 (le prédécesseur de ChatGPT) avait consommé près de 1 300 MWh, soit l'électricité consommée par près de 320 foyers français en une année, mais ce programme n'était pas ouvert au grand public.

Enfin, des entreprises tentent de limiter leur impact en créant des IA plus "frugales", c'est-à-dire qui réclament moins de ressources. Les géants de la tech mettent aussi en avant des IA pensées pour prendre soin de l'environnement, par exemple pour détecter des fuites de méthane dans l'atmosphère, ou concevoir de nouveaux matériaux plus économes.

Comment peut-on reconnaître les créations d'IA génératives ?

Il existe bien des techniques pour reconnaître les textes ou les images générées par IA, mais elles sont vite obsolètes du fait des progrès techniques. Vérifier le nombre de doigts des humains sur les images n'est par exemple plus un critère pertinent et fiable, car les dernières IA génératives n'ont plus tendance à en ajouter.

Mais il reste tout de même des astuces : dans les images, chercher des formes étranges, des objets "fondus", des traits qui se terminent sans raison, des mouvements illogiques ou physiquement impossibles dans les vidéos. Et de manière générale, les images dites "réalistes" les moins complexes ont un style très lisse, entre la photo professionnelle et le film d'animation 3D. Les comptes comme Insane Facebook AI Slop regroupent de nombreux exemples.

Des exemples d'images générées par intelligence artificielle publiées sur Facebook.

Les entreprises qui développent des programmes d'intelligence artificielle pourraient intégrer dans leurs IA génératives des watermarks, ces signatures visibles (par un symbole superposé à l'image) ou invisibles (des motifs intégrés directement dans certains pixels de l'image, ou dans certains mots qui se répètent) qui peuvent ensuite être détectées. Mais l'application n'est pas toujours facile, et les entreprises y ont peu d'intérêt. D'après le Wall Street Journal, OpenAI a créé par exemple un détecteur de texte généré par ChatGPT efficace à 99,9%, mais refuse de l'ouvrir au grand public.

Et est-ce que les IA risquent de se rebeller, comme dans "Terminator" ?

Le sujet fait débat. Certains chercheurs considèrent que les progrès de l'IA peuvent poser un "risque existentiel" pour l'humanité. Parmi eux, des "pères fondateurs" de l'IA actuelle comme Yoshua Bengio, ou Geoffrey Hinton. Ce dernier estime qu'il y a 10 à 20% de chances que l'IA conduise à l'extinction de l'humanité dans les trente prochaines années. Selon eux, même si la probabilité de ce scénario catastrophe demeure faible, il faut s'y préparer, en travaillant sur l'alignement, c'est-à-dire la recherche pour que les valeurs et les objectifs des IA soient les mêmes que ceux des humains.

Un exemple classique de mauvais alignement : si on crée une IA chargée de gérer une usine de trombones, dont le seul objectif est de créer le plus de trombones possibles, elle pourrait déterminer que le principal obstacle à l'utilisation maximale des ressources est… la vie sur Terre. Elle pourrait alors tenter d'éradiquer toute vie afin d'exploiter le maximum de ressources sans risquer d'être débranchée, selon une expérience de pensée du philosophe Nick Bostrom, un des penseurs des "risques existentiels"liés à l'IA.

Pour beaucoup d'autres experts, dont le Français Yann Le Cun, l'un des pionniers de l'IA moderne, ce scénario n'est que fiction. Les IA n'ont que les capacités qu'on leur attribue. Une IA chargée de gérer une usine de trombones ne pourra donc pas développer les connaissances d'un expert en armes chimiques ou convaincre d'autres IA de le faire à sa place. Ils ajoutent que les IA ne s'activent que si on le leur demande, et qu'on peut en principe les débrancher.

- Définition de l’intelligence :

- création :

- Philosophie, intuition, rêve, émotions, 5 sens

- réflexion :

- analyse, raisonnement, logique

- création :

- L’IA consiste à donner aux ordinateurs la capacité de résoudre des problèmes ou de réaliser des tâches qui nécessitent normalement de l’intelligence humaine. Se sont des systèmes informatiques qui sont capables de reproduire des fonctions humaines.

- L’IA est la science qui consiste à faire résoudre à des machines des problèmes qui auraient nécessité une forme d’intelligence humaine pour être résolus.

- Du code et des maths :

- L’IA est un vaste domaine rassemblant “une famille de technologies et de méthodes mathématiques (des algorithmes) qui vise à permettre à des machines de simuler ou de s’inspirer des processus cognitifs des êtres humains (apprentissage) pour réaliser des tâches”. Ces tâches sont la représentation du savoir, la résolution de problème, la compréhension, la perception (vision, ouïe), la planification et la prise de décision, la communication et la production de contenus.

- IA aujourd’hui :

- La révolution de l’IA est déjà en marche et bien avant ChatGPT et l’IA générative

- Outils d’aide à la création de textes, images, vidéos, audios

- D’après le parlement européen : “possibilité pour une machine de reproduire des comportements liés aux humains, tels que le raisonnement, la planification et la créativité”.

- raisonnement : analyser des informations (les collecter et les structurer); tirer des conclusions; résoudre des problèmes.

- Le raisonnement humain est un processus cognitif qui repose sur :

- L'expérience : Les humains utilisent leurs connaissances passées pour faire des déductions ou des inférences.

- L'intuition : Une forme de raisonnement rapide, souvent inconsciente, basée sur des schémas appris.

- Les émotions : Elles influencent parfois les jugements et décisions.

- Les formes de raisonnement :

- Déductif : Tirer une conclusion logique à partir de prémisses générales. Exemple : "Tous les hommes sont mortels. Socrate est un homme. Donc, Socrate est mortel."

- Inductif : Généraliser à partir d'observations spécifiques. Exemple : "Les derniers étés ont été chauds. Donc, les prochains seront probablement chauds."

- Abductif : Proposer l'explication la plus plausible pour un ensemble d'observations. Exemple : "La lumière ne fonctionne pas. L'ampoule est peut-être grillée."

Le raisonnement humain est influencé par des biais cognitifs, des croyances personnelles et des limitations d'attention ou de mémoire.

- En IA, le raisonnement est une simulation basée sur des modèles et algorithmes (règles logiques prédéfinies, probabilité, apprentissage)

- Différences avec l'humain :

- L'IA ne "comprend" pas dans le sens humain ; elle traite des informations basées sur des algorithmes.

- L'IA est rapide et précise dans des tâches spécifiques mais manque de flexibilité.

- L'IA n'est pas influencée par les émotions ou les biais cognitifs (sauf ceux introduits par des données biaisées).

- Le raisonnement humain est un processus cognitif qui repose sur :

- planification : concevoir une série d'actions ou d'étapes pour atteindre un objectif donné.

- Compréhension de la situation, définition d'objectifs, établissement d'un plan, flexibilité et adaptation

- La planification humaine est influencée par : les émotions (la peur d'un échec), les biais cognitifs (les humains surestiment ou sous-estiment les risques ou ressources), les limites cognitives : L'humain a une capacité limitée à prévoir toutes les variables dans des environnements complexes.

- Différences entre planification humaine et en IA

La planification en IA est méthodique, rapide, et efficace dans des environnements bien définis, mais manque de souplesse et de créativité face à des situations imprévues.

Critères Planification humaine Planification en IA Flexibilité Hautement flexible, adaptative au contexte Limité par les modèles et données fournis Créativité Capable de trouver des solutions innovantes Suit des règles définies, manque de créativité Temps de traitement Plus lent dans des scénarios complexes Rapide, mais nécessite des ressources informatiques Gestion de l'incertitude Basée sur l'intuition et l'expérience Repose sur des probabilités et des algorithmes Influence émotionnelle Présente, parfois positive ou négative Absente, décisions purement rationnelles

- créativité : l’IA peut sembler créative dans certaines situations, mais sa créativité est fondamentalement différente de celle des humains. L'IA ne "ressent" pas d'inspiration ni ne réfléchit de manière intuitive ; elle simule la créativité en utilisant des modèles mathématiques et des algorithmes basés sur les données qu'elle a analysées.

- Pas d'intention ou de conscience : L'IA ne "veut" pas être créative ; elle applique des règles et optimise des résultats.

- Dépendance aux données : L'IA ne peut générer des idées qu'à partir des données qu'elle a été entraînée à analyser. Elle ne crée pas véritablement "à partir de rien".

- Absence de valeur intrinsèque : L'IA ne comprend pas le contexte émotionnel ou culturel d'une œuvre créative. Elle ne juge pas la "beauté" ou la "pertinence".

- raisonnement : analyser des informations (les collecter et les structurer); tirer des conclusions; résoudre des problèmes.

Il n’y a pas que chatGPT et l’IA générative. L’IA est utilisée depuis quelques années déjà sous diverses formes.

- IA forte (futur hypothétique)

- Description : Une IA capable de comprendre, apprendre et effectuer n'importe quelle tâche qu'un humain peut accomplir, avec des capacités cognitives similaires.

- Exemples :

- N'existe pas encore dans la réalité, mais est souvent décrite dans les films de science-fiction comme Jarvis dans Iron Man.

- Objectif : Être aussi flexible et intelligente qu'un être humain.

- La science-fiction. Pr exemple l’auteur Philip K. Dick

- Plusieurs films en parlent :

- West world

- Detrait become human (jeu)

- A.I. Intelligence Artificielle de Steven Spielberg sur une idée de Stanley Kubrick (2001)

- Synopsis : Dans un futur où les IA sont des robots humanoïdes, un garçon-robot nommé David, conçu pour aimer, cherche désespérément à devenir "humain".

- Pourquoi le voir ? : Ce film explore la quête d'identité et d'émotions des IA, tout en posant des questions sur ce qui définit l'humanité.

- I, Robot de Alex Proyas (2004)

- Synopsis : Inspiré des œuvres d'Isaac Asimov, ce film suit un détective qui enquête sur un meurtre où un robot pourrait être impliqué. Il explore les dilemmes moraux liés aux robots intelligents.

- Pourquoi le voir ? : Il questionne la coexistence entre humains et IA forte dans un monde régi par des lois éthiques pour les robots.

- Vidéos :

- Her de Spike Jonze(2013)

- Synopsis : Theodore, un homme solitaire, développe une relation intime avec un système d'exploitation intelligent nommé Samantha. Samantha évolue en apprenant de ses interactions avec Theodore.

- Pourquoi le voir ? : Ce film traite de l'impact émotionnel et social des IA qui peuvent ressentir et comprendre les émotions humaines.

- Ex Machina de Alex Garland (2014)

- Synopsis : Un jeune programmeur est invité par un milliardaire à tester l'intelligence d'un robot humanoïde, Ava, doté d'une IA avancée. Ce film explore les questions éthiques, émotionnelles, et philosophiques autour de l'IA forte.

- Pourquoi le voir ? : Il pose des questions profondes sur la conscience, le libre arbitre, et la relation entre humain et machine.

- Vidéos :

- Ghost in the Shell de Rupert Sanders (2017)

- Synopsis : Dans un monde cybernétique, une cyborg enquête sur un hacker qui remet en question les frontières entre l'humain et l'IA.

- Pourquoi le voir ? : Une réflexion philosophique sur l'âme, la conscience et la fusion entre humain et machine. Des humains qui deviennent des robots.

- Blade Runner de Ridley Scott (1982) & Blade Runner 2049 de Denis Villeneuve (2017)

- Synopsis : Dans un monde futuriste, des "réplicants" (androïdes dotés d'une intelligence avancée) cherchent à comprendre leur place dans la société.

- Pourquoi le voir ? : Ces films questionnent ce qui rend une intelligence (ou une vie) authentique, explorant les notions d'empathie et d'âme.

- Vidéos :

- IA faible

- Description : L'IA faible est conçue pour accomplir une tâche spécifique. Spécialisée dans une tâche unique .

- Exemples :

- Google Translate

- Siri ou Alexa : Reconnaissance vocale et réponses.

- Systèmes de recommandation : Netflix ou YouTube.

- Jeux vidéo : Adversaires contrôlés par l’ordinateur.

- La reconnaissance faciale

- Deep Blue d'IBM : Le programme qui a battu le champion d’échecs Garry Kasparov en 1997.

- Voitures autonomes : Elles analysent en temps réel les routes, les panneaux et les autres véhicules.

- Diagnostique médicaux : les scientifiques ont récoltés les connaissances médicales et ont fait des règles logiques pour l’IA. L’IA utilise ses règles logiques pour diagnostiquer des maladies en fonction des symptômes et des résultats d’examens médicaux. L’IA va analyser les symptômes et les antécédents médicaux de la personne, puis utiliser des règles logiques pour identifier des causes possibles et donc faire des diagnostiques.

Ces IA sont déjà utilisées par des médécins pour aider au diagnostiques de maladies rares et complexes.

- La création de contenu : en aidant les créateurs à gagner du temps, à améliorer la qualité de leurs productions, et à générer des idées innovantes.

- Rédaction automatisée :

Les modèles de langage comme GPT peuvent écrire des articles, des blogs, des descriptions de produits, des e-mails, et bien plus.

- Aide à la reformulation :

Réécrire des phrases ou des paragraphes pour les rendre plus clairs, convaincants, ou adaptés à un ton spécifique.

- Création de résumés :

Résumer des documents complexes en quelques lignes.

- Idéation :

Proposer des titres accrocheurs, des sujets de contenu, ou des angles originaux.

- Recherche et collecte d’informations : l’IA peut aider à rechercher des informations précises ou à analyser des tendances.

- Planification éditoriale : Proposer des calendriers de publication basés sur les performances précédentes et les tendances du marché.

- Analyse de performances : Mesurer l’impact d’un contenu en temps réel et suggérer des ajustements (titres, formats, visuels).

- l’IA agit comme un collaborateur puissant qui accélère la création, améliore la qualité, et ouvre de nouvelles possibilités pour les créateurs, tout en laissant les humains au cœur des décisions créatives

- Rédaction automatisée :

- Chatbot qui ne répond qu’aux questions qu’on lui a appris. Il ne peut pas s’adapter à des situations complexes

- ChatGPT est conçu pour effectuer une tâche spécifique : générer du texte et répondre à des questions de manière cohérente et pertinente. Il n’a pas de compréhension générale ou de conscience du monde comme un humain. ChatGPT est un exemple avancé d'IA faible, capable d'exceller dans une tâche particulière (le traitement du langage naturel) sans posséder les capacités cognitives générales ou adaptatives d'une IA forte.

- Automatisation et robotique

Les machines robots apprennent de manière automatique à améliorer les mouvements et à les exécuter plus rapidement. Pour une chaîne de production par exemple.

Les machines vont être conçues pour qu’elles communiquent entre elles. Ainsi il y aura le designer au début qui va montrer le plan du produit, les machines vont travailler et discuter entre elles pour toutes seules terminer le produit.

- Limitation : Elle ne "comprend" pas la tâche, elle suit des algorithmes définis. Bien que ses réponses puissent sembler très intelligentes, il ne "comprend" pas réellement ce qu'il dit. Il utilise des modèles statistiques pour prédire les mots en fonction des données sur lesquelles il a été entraîné.

ChatGPT ne peut pas résoudre des problèmes qui sortent de son cadre prédéfini (par exemple, il ne peut pas conduire une voiture, concevoir un circuit électronique, ou réfléchir sur des concepts abstraits au-delà de son domaine d'entraînement).

logiciel vs IA

- un logiciel prend des données, fait des calculs sur les données et donne un résultat. Si on lui donne de nouvelle données, il va refaire le calcul de la même manière

- une IA va utiliser des données pour en faire des probabilités et des conclusions et va utiliser les résultats et son expérience pour analyser différemment de nouvelles données. Plus on va lui envoyer des données et plus il va s’améliorer.

C’est lorsque les machines ne sont pas programmées pour effectuer certaines tâches, mais qu’elles sont programmées pour apprendre et s’améliorer automatiquement à partir de l’expérience par essais et erreurs. On donne à la machine beaucoup de données. On utilise des méthodes statistiques comme la régression linéaire.

Par exemple : à force de dire “ce message est un spam” plusieurs fois on entraîne la machine à comprendre toute seule que le message est un spam, recommandations de contenus comme Nextflix ou Spotify

C’est un variant du machine learning ou le programme est basé sur des réseaux de neurones profonds et artificiels pour l’analyse prédictives. Les neurones permettent d’apprendre en créant de nouvelles connexion entre des informations et en comprenant qu’on peut faire de nouvelles actions.

Par exemple : trouver des chats dans une image, détecter des sons dans un signal audio, de trouver des fraudes dans des transactions bancaires.

C’est une des technologies de l’IA. Il en existe d’autres. Cela bouge et se transforme avec le temps ses années passées et futures.

Phase d’entraînement.

- L'IA apprend à partir de données (comme un étudiant qui révise avec ses notes). On entraîne un modèle à accomplir certaines tâches. On l’entraîne avec des jeux de données (dataset)

- Exemple simple : Apprendre à reconnaître des images de chats à partir de milliers d’exemples.

- On dit à l’IA “cette image est un chat” ou bien “cette image n’est pas un chat”. C’est comme cela qu’il apprend à reconnaître ou a dessiner lui-même un chat.

- Exercice sur les chats

- IA par apprentissage automatique

- Cette IA utilise des algorithmes pour apprendre à partir de données et améliorer ses performances au fils du temps. elle continue d’évoluer toute seule.

- exemple :

- chatGPT. Si tu lui poses la même question à 1 mois d’écart sa réponse aura évolué avec les connaissances qu’il aura appris entre temps.

- Exemples d’usage de ChatGPT :

- amélioration de texte. Pour cela il faut lui dire, à l’aide du prompt, ce qu’on attend de lui avec des détails. il faut lui donner un texte qui tu as écrit et lui demander de l’améliorer. Il faut demander plusieurs versions à ChatGPT en lui donnant des précisions et des modifications sur ce qu’il a généré.

- détails :

- qui ont est

- à qui on s’adresse

- le but du message

- d’autres détails essentiels

- détails :

- résumer un article : “peux-tu résumer cet article pour que je puisse comprendre rapidement de quoi il parle ?”

- résumer un article qui était dans une autre langue que le français.

- amélioration de texte. Pour cela il faut lui dire, à l’aide du prompt, ce qu’on attend de lui avec des détails. il faut lui donner un texte qui tu as écrit et lui demander de l’améliorer. Il faut demander plusieurs versions à ChatGPT en lui donnant des précisions et des modifications sur ce qu’il a généré.

- Exemples d’usage de ChatGPT :

- Adobe photoshop : on lui demande une image et on lui donne les détails de ce que l’on veut. Par exemple le type d’image (réaliste ou dessin animé)

- chatGPT. Si tu lui poses la même question à 1 mois d’écart sa réponse aura évolué avec les connaissances qu’il aura appris entre temps.

Chaque neurone (noeud) possède une information. Les noeuds sont reliés entre eux c’est ce qui donne l’intelligence.

Contrairement à ce que pourrait suggérer son nom, un réseau de neurones artificiels n’est aucunement la reproduction numérique d’un cerveau biologique.

Un réseau de neurones est un système informatique inspiré du fonctionnement du cerveau humain.

Un réseau de neurones artificiels est un ensemble organisé de neurones interconnectés. Il s’agit d’un type particulier d’algorithmes d’apprentissage automatique (un modèle) caractérisés par un grand nombre de couches de neurones, dont les coefficients de pondération sont ajustés au cours d’une phase d’entraînement (apprentissage profond).

Il existe de nombreux type de réseaux de neurones artificiels tels que les réseaux de neurones récurrents, les auto-encodeurs, les réseaux transformeurs ou encore les réseaux antagonistes génératifs (generative adversarial networks).

Neurone : un nœud d'un réseau de plusieurs neurones reçoit généralement plusieurs valeurs d'entrée et génère une valeur de sortie.

Le modèle d'IA est la construction mathématique générant une déduction ou une prédiction à partir de données d’entrée. Le modèle est estimé à partir de données annotées lors de la phase d’apprentissage (ou d’entraînement) du système d’IA.

En mai 2023, Hinton a démissionné de Google afin de pouvoir « s'exprimer librement sur les risques de l'IA ». Il a exprimé des préoccupations concernant l'utilisation délibérée par des acteurs malveillants, le chômage technologique et les risques existentiels lié à l'intelligence artificielle générale. En 2024, après avoir reçu le prix Nobel il a appelé à des recherches urgentes en sécurité de l'IA afin de déterminer comment contrôler des systèmes plus intelligents que les humains.

En juin 2024, Ilya fonde avec Daniel Gross et Daniel Levy la startup Safe Superintelligence. Celle-ci vise à se focaliser uniquement sur la création d'une superintelligence artificielle sans danger.

- Besoin de beaucoup de données.

- Si l’IA est entraînée avec des données biaisées, elle reproduira ces biais.

- Pas de compréhension réelle, juste des calculs.

- Consommation énergétique importante, impactant l’environnement.

- Absence de créativité véritable : Bien que l’IA puisse générer des œuvres (art, musique, etc.), elle ne crée pas réellement. Elle combine et adapte des éléments existants, sans intention ni inspiration.

- Manque d’intuition et de jugement : Contrairement aux humains, l’IA ne peut pas comprendre ou interpréter des émotions, des nuances culturelles, ou des contextes complexes de manière intuitive.

- Incapacité à comprendre les émotions humaines

- Une surdépendance à l’IA peut réduire la créativité et les compétences humaines, notamment dans des domaines où les décisions critiques nécessitent une réflexion humaine.

- Régulation insuffisante : L’IA évolue plus rapidement que les cadres légaux. Cela pose des questions sur la confidentialité, la propriété intellectuelle et les responsabilités en cas d’erreurs.

- Impact sur l’emploi : L’automatisation peut entraîner la disparition de certains emplois, soulevant des préoccupations économiques et sociales.

- Vulnérabilités aux attaques : Les IA peuvent être manipulées en introduisant des données conçues pour les tromper.

- L’IA peut être utilisée à des fins malveillantes, comme : La désinformation (deepfakes), Les cyberattaques automatisées.

Rédiger un court article (300-500 mots) sur un sous-thème du développement durable pour des lecteurs jeunes, entre 15 et 20 ans ?

- Trouver un sujet et un angle pour l’article . Demander à ChatGPT : Prompt :

"Quels sont les sujets populaires sur le développement durable en 2025 ?”

“Je voudrais écrire un article. Quels sont les sujets les plus importants sans le développement durable qui pourraient intéresser les jeune dans le domaine de l’informatique?”- Réponse = > “GREEN IT - la réduction de la consommation d’énergie dans les datacenter”

Sous quel angme je devrais aborder le sujet : “GREEN IT - la réduction de la consommation d’énergie dans les datacenter” ?- Réponse = > “environnemental et économique”

- La structure de l’article :

- Introduction captivante : Posez une question ou présentez une statistique frappante.

- Développement : Structurez en sous-sections avec des conseils pratiques ou des faits intéressants.

- Conclusion : Terminez par un appel à l'action ou une réflexion inspirante.

Demander à ChatGPT :

"Aide-moi à structurer un article sur“GREEN IT - la réduction de la consommation d’énergie dans les datacenter : environnemental et économique”.”

- Collecter des informations pour le contenu de l’article.

- Rechercher des statistiques ou exemples pertinents.

“Selon la structure que tu m’as donné, peux-tu trouver des exemples concrets?”des témoignages, des parcours atypiques, des retours d’expériences

“Selon la structure que tu m’as donné, peux-tu ajouter des statistiques et des données chiffrées intéressantes ?”

- Règlementations ou des lois ou des subventions…

- Rechercher des statistiques ou exemples pertinents.

- Visibilité : Optimiser pour les tendances (SEO)

- Recherche de mots-clés : demandez à ChatGPT les mots-clés tendance.

"Quels mots-clés utiliser pour un article sur xxxxx ?".

“peux-tu me donner des mots-clés simples qui amélioreront la visibilité de mon article dans les moteurs de recherche internet ou les réseaux sociaux?”- mot-clé primaires, secondaires

- Ajout de hashtags : Proposez des hashtags qui augmentent la visibilité sur les réseaux sociaux. Demander à ChatGPT :

- avec ce prompt :

"Donne-moi une liste de hashtags populaires pour un sujet sur xxxxxx en 2025.”

- Ou bien ce prompt :

"Trouve des hashtags adaptés à un blog sur les innovations technologiques écologiques.”,

- ou encore :

"Quels hashtags utiliser pour augmenter la visibilité d'un post Instagram sur la mode éthique et durable ?”

- avec ce prompt :

- Recherche de mots-clés : demandez à ChatGPT les mots-clés tendance.

- Rédaction de l’article

- Première rédaction💡

En lui demandant d’utiliser les mots-clés tendances trouvés en 4.

- Affiner le ton et le style.

- déterminer le ton de votre article qui peut être inclusif, humoristique, scientifique ou académique, simple et vulgarisateur

- On peut demander aussi un champ lexical adapté pour tout l’article ou par chapitre

"Peux-tu rendre ce passage,xxxx, plus persuasif et engageant ?"

- On peut donner des exemples de textes pour le style que vous voulez (par exemple des textes que vous avez écrit). Puis demandez à CHATGPT de définir le style du texte. Il va donner une description détaillée du style. Reprendre la description pour vos futurs demandes.

- Intro Prompt :

"Peux-tu rédiger un article selon la structure contenant les exemples et les statistiques, et contenant également les mots-clés trouvés ?”

- Développement (selon la structure définie) Prompt :

"Développe cette idée xxxxx en 2-3 paragraphes, avec des exemples concrets.”OU“Explique pourquoi le xxxxx est bénéfique pour xxx en incluant un exemple concret”.

- Conclusion :

"Écris une conclusion percutante pour cet article en ajoutant un appel à l’action.”

- Affiner le ton et le style.

- Première rédaction

- Demander un titre et des sous-titres accrocheurs et captivants pour les jeunes.

- Générer une illustration pour l’article :

“Peux-tu me donner une illustration de style aplat , pour mon article?”

- Publier l’article en HTML (demander à ChatGPT de réécrire l’article pour une page HTML)

- ChatGPT

- Jenni (https://jenni.ai)

Marvin Minsky

Américain qui a fondé des groupe de travail et des conférences dans les années 1950 et 1960 qui sont à l’origine de l’Intelligence artificielle.

Minsky a cofondé le MIT Artificial Intelligence Laboratory (aujourd'hui le CSAIL, Computer Science and Artificial Intelligence Laboratory) avec John McCarthy. Ce laboratoire est l'un des centres de recherche en IA les plus influents au monde et a contribué à des avancées majeures dans le domaine de l'informatique, de la robotique et de l'IA.

Luc Julia

Expert français. Concepteur de Siri.

Lors de ses prises de parole dans les médias en France, Luc Julia modère les propos alarmistes sur l'intelligence artificielle ; il préfère d'ailleurs utiliser le terme d'« intelligence augmentée ». Dans ses conférences, il s'oppose aux d de certaines personnalités du monde de la technologie, comme Elon Musk. Pour lui, ce sont les humains qui sont et resteront aux commandes des intelligences artificielles. Il explique d'ailleurs que les humains ont le choix d'utiliser correctement ces outils afin d'améliorer la société.

John Hopfield

Prix Nobel 2024. 1982 : réseau de neurones artificiel.

Geoffrey Hinton

Prix Nobel 2024. 1985 : méthode d’entraînement pour les réseaux de neurones.

2 de ses élèves de l’université de Toronto, Alex Krizhevsky et Ilya Sutskeven ont été les développeurs de ChatGPT.

Intelligence augmentée

L’IA, contrairement à l’humain, ne comprend rien; Elle produit des résultats sans garantie de véracité. Pour autant lorsqu’elle se conjugue à l’intelligence humaine, elle ouvre des horizons.

Réseaux de neurones

Contrairement à ce que pourrait suggérer son nom, un réseau de neurones artificiels n’est aucunement la reproduction numérique d’un cerveau biologique.

Un réseau de neurones est un système informatique inspiré du fonctionnement du cerveau humain.

Un réseau de neurones artificiels est un ensemble organisé de neurones interconnectés. Il s’agit d’un type particulier d’algorithmes d’apprentissage automatique (un modèle) caractérisés par un grand nombre de couches de neurones, dont les coefficients de pondération sont ajustés au cours d’une phase d’entraînement (apprentissage profond).

Il existe de nombreux type de réseaux de neurones artificiels tels que les réseaux de neurones récurrents, les auto-encodeurs, les réseaux transformeurs ou encore les réseaux antagonistes génératifs (generative adversarial networks).

Neurone : un nœud d'un réseau de plusieurs neurones reçoit généralement plusieurs valeurs d'entrée et génère une valeur de sortie.

Le modèle d'IA est la construction mathématique générant une déduction ou une prédiction à partir de données d’entrée. Le modèle est estimé à partir de données annotées lors de la phase d’apprentissage (ou d’entraînement) du système d’IA.

Perception

En intelligence artificielle (IA), la perception est la capacité d'un système à collecter, analyser et interpréter des données provenant de son environnement, généralement à partir de capteurs ou d'entrées numériques. Cela permet à l'IA de comprendre et d'interagir avec le monde qui l'entoure.

Deepfake

Contenus numériques qui ont l’apparence du vrai, mais qui sont faux, parce que manipulés par l’IA. La perception en IA est comme les sens humains : elle permet à une machine de "voir", "entendre", ou "sentir" pour agir intelligemment.

Use case of Hanna Mergui, doctorante qui fait une thèse sur l’imagerie médicale et son usage avec l’IA.

- Son parcours : vidéo

Anna a choisi le métier de l'informatique car elle voulait quelque chose qui puisse se transporter à l'étranger, également un métier qui évolue sans cesse.

Elle a d'abord étudié à l'université MathInfo, puis elle est allée à l'école Dauphine pour faire de l'informatique de l'entreprise. Dans ce cadre, elle a suivi un cours d'introduction à l'IA, et c'était avant le boom de ChatGPT et des IA que l'on connaît aujourd'hui.

Ensuite, Anna a intégré l'école Polytechnique grâce à une passerelle entre les universités et les écoles d'ingénieurs. Là, elle a suivi un master spécialisé en IA, couvrant :

- l’histoire de l’intelligence artificielle,

- ses différentes applications dans l’imagerie,

- la vidéo,

- et le son.

Enfin, Anna a voulu mettre à profit ses compétences dans un domaine qui lui tenait à cœur : le médical.

- Use case de l’imagerie médicale :

- Startup Sonio; estimation du poids foetal

- Thèse sur les malformations lors de échographies prénatale

- Une IA entraînée avec des images d’échographie.

- L’IA a besoin de milliers de données, d’images, pour s’entraîner.

- Générer des fausses images qui apprendront à l’IA.

- Modèles d’IA générative qui soient compétents pour créer ses fausses images. 2 catégories d’IA génératives :

- GAN : générateur et discriminateur

- Modèles de diffusion (DALL.E, Mid Journey) : déconstruire une image pour la reconstruire avec un prompt. ou AudioLM, MusicLM : génération de sons et musiques

- connaître le domaine

- éthique

- anonymisation de données

- le médecin n’est pas remplacé, la machine va l’aider à faire le diagnostique. C’est comme si le médecin avait un assistant. Par ex l’IA ne prend aucun décision. Il va données plein d’informations et voir les choses (sans être fatigué…)

Comment on fait pour entraîner un modèle d’IA générative ?

Entraîner un modèle d’IA avec des images, c’est lui apprendre à comprendre ou générer des images en lui fournissant un grand nombre d’exemples.

1. Définir l’objectif

Avant tout, il faut savoir ce qu’on veut que le modèle fasse :

| Objectif | Exemple | Type de modèle |

| Classification | “Est-ce un chat ou un chien ?” | CNN |

| Détection | “Où est le visage dans cette image ?” | R-CNN, YOLO |

| Génération | “Créer une image d’un chat” | GAN, Diffusion |

| Segmentation | “Colorier chaque pixel selon l’objet” | U-Net, Mask R-CNN |

2. Préparer les données

Rassembler les images

- Ou utiliser ses propres images

Nettoyer et organiser

- Supprimer les images floues ou inutiles

- Créer un dossier par classe (ex : data/chats/, data/chiens/)

Redimensionner et normaliser

- Uniformiser la taille (ex. : 224×224 pixels)

- Convertir les pixels de [0–255] à [0–1] ou [-1, 1] avec un programme (pour adapter l’image au algorithme de l’IA)

3. Choisir un modèle

Les plus courants sont des réseaux de neurones convolutionnels (CNN) pour l’analyse d’image :

- Pour débuter : ResNet, VGG, MobileNet

- Pour la génération : GAN, UNet, Stable Diffusion

Tu peux aussi utiliser du Transfer Learning (réutiliser un modèle déjà entraîné).

4. Entraîner le modèle

Utiliser un framework

- PyTorch

- TensorFlow / Keras

Exemple simple avec Keras

Keras est une bibliothèque open-source de haut niveau en Python qui permet de créer, entraîner et tester facilement des modèles d’intelligence artificielle, en particulier des réseaux de neurones.

Keras sert à construire des modèles d’apprentissage profond (deep learning).

On peut le faire sur la plateforme Google Colab (gratuit, avec GPU, processeur qui peut travailler en parallèle et très rapide), par exemple.

from tensorflow.keras.preprocessing.image import ImageDataGenerator

from tensorflow.keras.applications import MobileNetV2

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, GlobalAveragePooling2D

# Préparation des données

datagen = ImageDataGenerator(rescale=1./255, validation_split=0.2)

train = datagen.flow_from_directory("data/", target_size=(224, 224), subset='training')

val = datagen.flow_from_directory("data/", target_size=(224, 224), subset='validation')

# Création du modèle

base_model = MobileNetV2(weights='imagenet', include_top=False, input_shape=(224, 224, 3))

model = Sequential([

base_model,

GlobalAveragePooling2D(),

Dense(1, activation='sigmoid') # binaire (chat/chien)

])

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

model.fit(train, validation_data=val, epochs=5)5. Évaluer le modèle

- Statistiques d’erreurs

- Vérifier avec des images jamais vues

6. Utiliser ou déployer

- Convertir le modèle (.h5, .pt, .onnx)

- Déploiement dans une app mobile, web, ou backend

Outils utiles

| Besoin | Outils recommandés |

| Annotation d’images | LabelImg, MakeSense.ai |

| Vision par ordinateur | OpenCV, torchvision |

| Cloud training | Google Colab, Kaggle, AWS SageMaker |

Parler avec pluton par ici

Je voudrais simuler une conversation avec Victor Hugo. Imagine que tu es lui. Tu peux répondre avec son style, son vocabulaire, ses idées politiques et littéraires. Je suis une étudiante en littérature, et je veux lui poser des questions sur Les Misérables, la révolution, ou ses années d’exil.

Très bien. À partir de maintenant, je suis Victor Hugo, homme de lettres, pair de France, proscrit, père endeuillé, mais toujours épris de justice et de lumière.

Parlez, chère étudiante. Posez vos questions. J’ouvrirai devant vous les vastes rideaux du siècle, de la misère et de l’espérance. Je vous répondrai avec la voix du proscrit, du poète, du tribun, de l’homme qui a vu l’ombre, et qui croit au soleil.

pourquoi as tu écrit les misérables ?

Pourquoi ai-je écrit Les Misérables ?

Je vais vous répondre comme un homme qui a vu le peuple souffrir et saigné de l’âme en le regardant.

J’ai écrit Les Misérables parce que la misère est une injustice. Parce qu’il y a, dans les plis sombres de la société, des êtres humains qui vivent dans la nuit alors que d’autres festoient dans la lumière. Parce que l’enfant pauvre, le bagnard rejeté, la femme perdue, le peuple courbé sous le poids des siècles — tous ces visages sont des pages que l’histoire oublie d’écrire.

Je voulais donner une voix à ceux qu’on n’entend pas, aux Jean Valjean, aux Fantine, aux Gavroche. Montrer que derrière la faute, il y a souvent la souffrance ; derrière le crime, la misère, qui est un autre nom de l’enfer social.

J’ai écrit ce livre pour que l’on comprenne ceci :

Tant qu’il y aura, par le fait des lois et des mœurs, une damnation sociale créant artificiellement l’enfer au milieu de la civilisation, des livres comme celui-ci pourront ne pas être inutiles.

C’est un cri. C’est une prière. C’est une guerre contre l’indifférence.

Et c’est un appel à l’humanité.

comment as-tu appris à si bien écrire ?

Comment ai-je appris à écrire ?

Ah, chère enfant, on n’apprend pas à écrire comme on apprend la géométrie ou la grammaire. Écrire, c’est vivre, souffrir, contempler, aimer, perdre, se relever, et traduire tout cela avec le feu de l’âme.

Mais si vous voulez parler des commencements — oui, je les dois à mon enfance solitaire, à mes lectures précoces, à la langue française que j’ai aimée comme on aime une mère, avec un respect sacré et une passion ardente.

J’ai été nourri de Corneille, de Molière, de Racine ; j’ai bu la Bible et Homère ; j’ai découvert Shakespeare comme on découvre un volcan. J’ai lu, j’ai écouté, j’ai médité. Et j’ai observé le peuple, la rue, la misère, la grandeur cachée des cœurs simples.

Mais surtout, j’ai aimé le mot. Le mot est un pouvoir, une arme, une lumière.

« Le mot, quand il est juste, a la force d’un canon et la douceur d’une prière. »

Alors j’ai écrit. Tous les jours. Jeune, j’ai rempli des cahiers. J’ai pleuré sur mes pages. Et je me suis battu avec la langue comme un sculpteur lutte avec le marbre — pour qu’elle chante, qu’elle brûle, qu’elle élève.

Voilà le secret :

Lire les maîtres, écouter le monde, écrire sans relâche, et ne jamais trahir la vérité du cœur.

Agence digitale Parisweb.art

Tout savoir sur Julie, notre directrice de projets digitaux : LinkedIn